Gestensteuerung für die Roboter/Mensch-Kommunikation

Handzeichen

Im Rahmen des 3DSensation-Projektes sollen Roboter zukünftig über Gestensteuerungen mithilfe einer 3D-Erfassung in Echtzeit und sofortiger Datenanalyse Menschen erkennen und ihre jeweiligen Gesten verstehen.

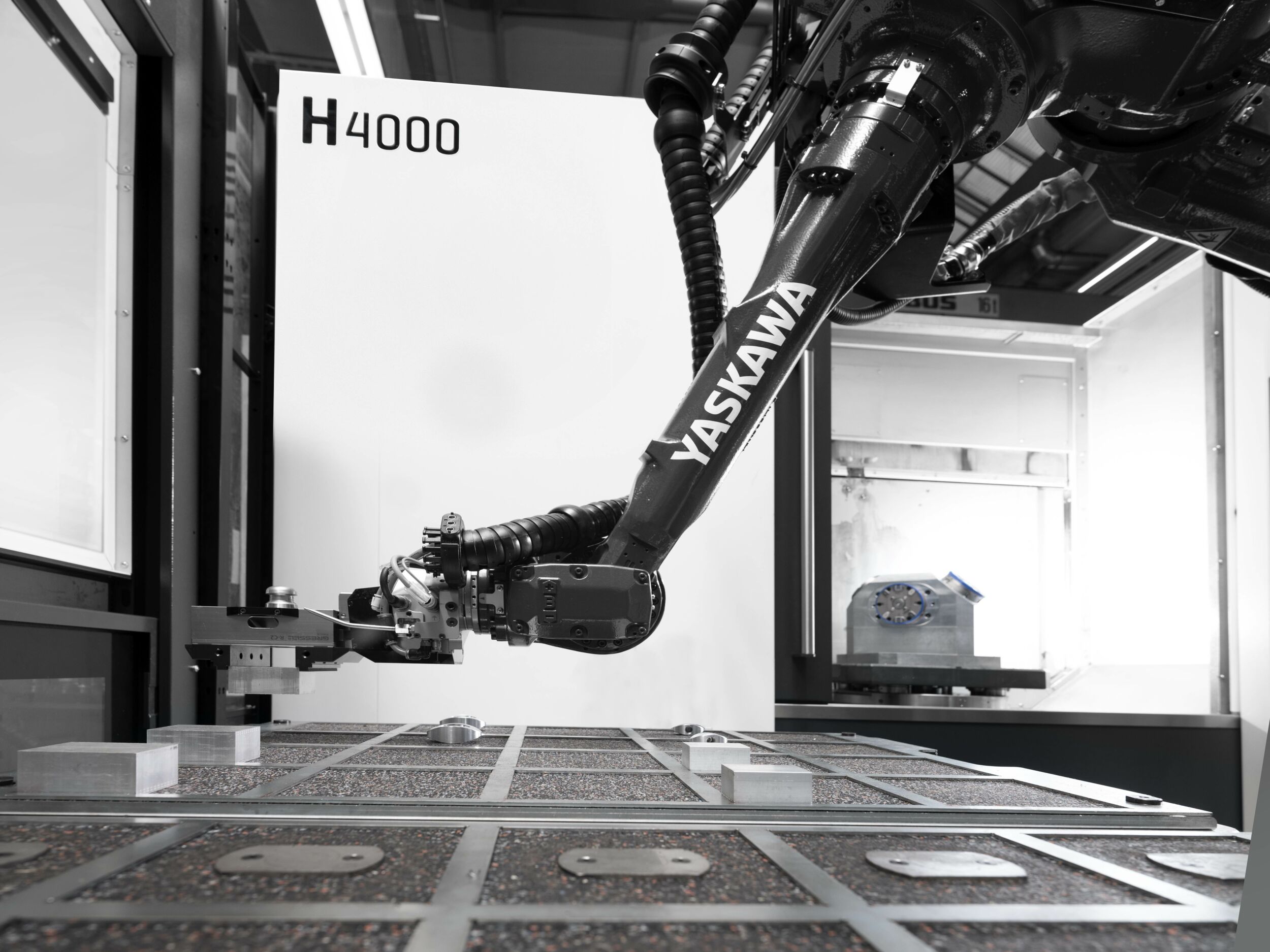

Mit 3D-Gestensteuerung können Roboter zukünftig die Gesten eines Anwenders erkennen und sofort präzise reagieren. (Bild: Fraunhofer HHI)

Verschiedene Projekte haben in den letzten Jahren die Kollaboration von Mensch und Maschine untersucht und prognostizieren, dass Mensch und Maschine zukünftig enger zusammenarbeiten werden. Sensitive Roboter sollen beispielsweise den Menschen erkennen und mit ihm in nicht abgeschlossen Roboterzellen interagieren. Damit beide Seiten gute Ergebnisse erzielen, müssen sie allerdings miteinander kommunizieren können. Tastatur und Maus sind dafür unpraktisch, eine Sprachsteuerung im industriellen Umfeld nicht immer zulässig. Eine Gestensteuerung dagegen ist intuitiv und findet schon heute viele Anwendungsmöglichkeiten. Für die genaue Erkennung menschlicher Gesten durch einen Roboter ist allerdings eine 3D-Datenerfassung in Echtzeit nötig. Am Fraunhofer IOF wird dafür seit Jahren an schnellen Systemen für die Aufnahme und Verarbeitung von 3D-Daten geforscht.

Trick aus der Theaterbeleuchtung

Die Projektionseinheit des 3D-Scanners muss dabei zwei Aufgaben lösen: Zuerst einmal muss sie genügend Licht auf das Objekt bringen, damit Aufnahmen auch bei Belichtungszeiten deutlich unter einer Tausendstelsekunde möglich sind. In so einem Fall gehen die Anforderungen an den Lichtstrom schnell in den Bereich von mehreren Tausend Lumen. Außerdem projiziert das System ein schnell variierendes Muster auf die Objektoberfläche. Das ist nötig, um korrespondierende Punkte in den Aufnahmen der beiden Kameras zuordnen zu können. So kann der Computer aus einem Satz von 2D-Bildern der beiden Kameras jeweils ein 3D-Bild errechnen. Um mit einem einfachen Aufbau einen hohen Lichtstrom zu erzeugen, haben die Fraunhofer-Institute einen Trick aus der Theaterbeleuchtung aufgegriffen: Dort steckt man hitzebeständige Glas- oder Metallfilter zwischen Lichtquelle und Optik, um Bilder oder Texte auf eine Leinwand zu bringen. Die Jenaer Forscher lassen zwischen Lichtquelle und Optik ein Metallfilter mit verschieden breiten Schlitzen rotieren. Damit erzeugen sie ein aperiodisches Streifenmuster auf dem Objekt, was die gewünschte Zuordnung ermöglicht. In ihrem ursprünglichen Set-up für Aufgaben in der Qualitätssicherung war der Scheinwerfer dabei 575W stark und ermöglichte über 1.300 Bilder pro Sekunde. In der Version für die Gestenerkennung reicht eine 4,5W-LED-Lichtquelle. Sie strahlt im nahen Infrarotbereich und ist daher für den Menschen komplett unsichtbar. Für die Gestenerkennung werden 360 Muster pro Sekunde projiziert. Mit zwei High-Speed-NIR-Kameras und einer Farbkamera werden bei jedem Muster Bilder vom beleuchteten Objekt aufgenommen und mit einer speziellen Software zu 36 3D-Datensätzen pro Sekunde umgerechnet. Abhängig vom Abstand sind mit den 1MP-Kameras Auflösungen bis in den Submillimeterbereich möglich.

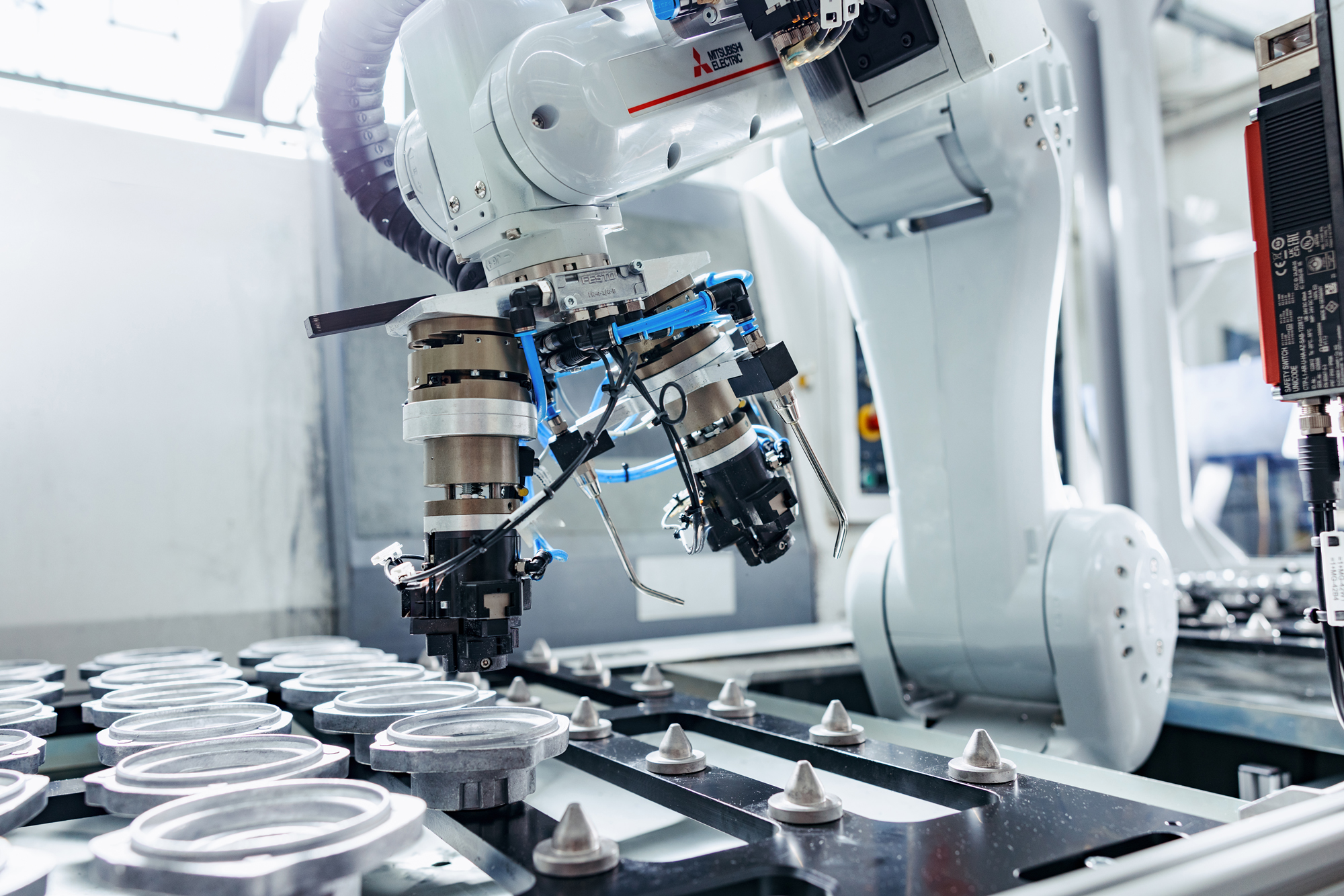

Piktogramme zeigen dem Anwender, auf welche Gesten der Roboter trainiert ist. (Bild: Fraunhofer HHI)

Vielfältige Einsatzgebiete

Für die intuitive Kommunikation mit Maschinen müssen die 3D-Daten latenzfrei analysiert werden. Paul Chojecki vom Fraunhofer HHI leitet die Arbeiten zur gestenbasierten Mensch/Maschine-Interaktion: „Uns ging es von Anfang an um eine Software für eine möglichst natürliche und effiziente Kommunikation. Letztlich soll sich die Maschine an den Benutzer anpassen.“ Dafür haben die Experten eine lernfähige Software auf Basis neuronaler Netze entwickelt. Langfristig sind verschiedene Szenarien geplant. Naheliegend ist dabei die Mensch/Maschine-Kollaboration im Fertigungsumfeld. Ein anderes Szenario ist die kontaktfreie Bedienung von Computerdisplays, beispielsweise bei Operationen. Mit bestimmten Gesten kann der Chirurg dann Fenster auf einem Display aufrufen oder Programme bedienen, ohne eine Tastatur berühren zu müssen. Großes Potenzial wird auch im Pflegebereich gesehen. Eine Kombination mit Methoden der Virtual Reality (VR) oder Augmented Reality (AR) sind ebenso naheliegend wie Anwendungen im Werbebereich (Gesichtserkennung) oder der Sicherheitstechnik. Die Innovationsallianz 3Dsensation trifft sich zu einem Innovationsforum mit dem Fokus auf die Mensch/Maschine-Interaktion vom 23. bis 25. Oktober in Jena.