Stereovision für das räumliche Sehen von Robotern

See and Pick

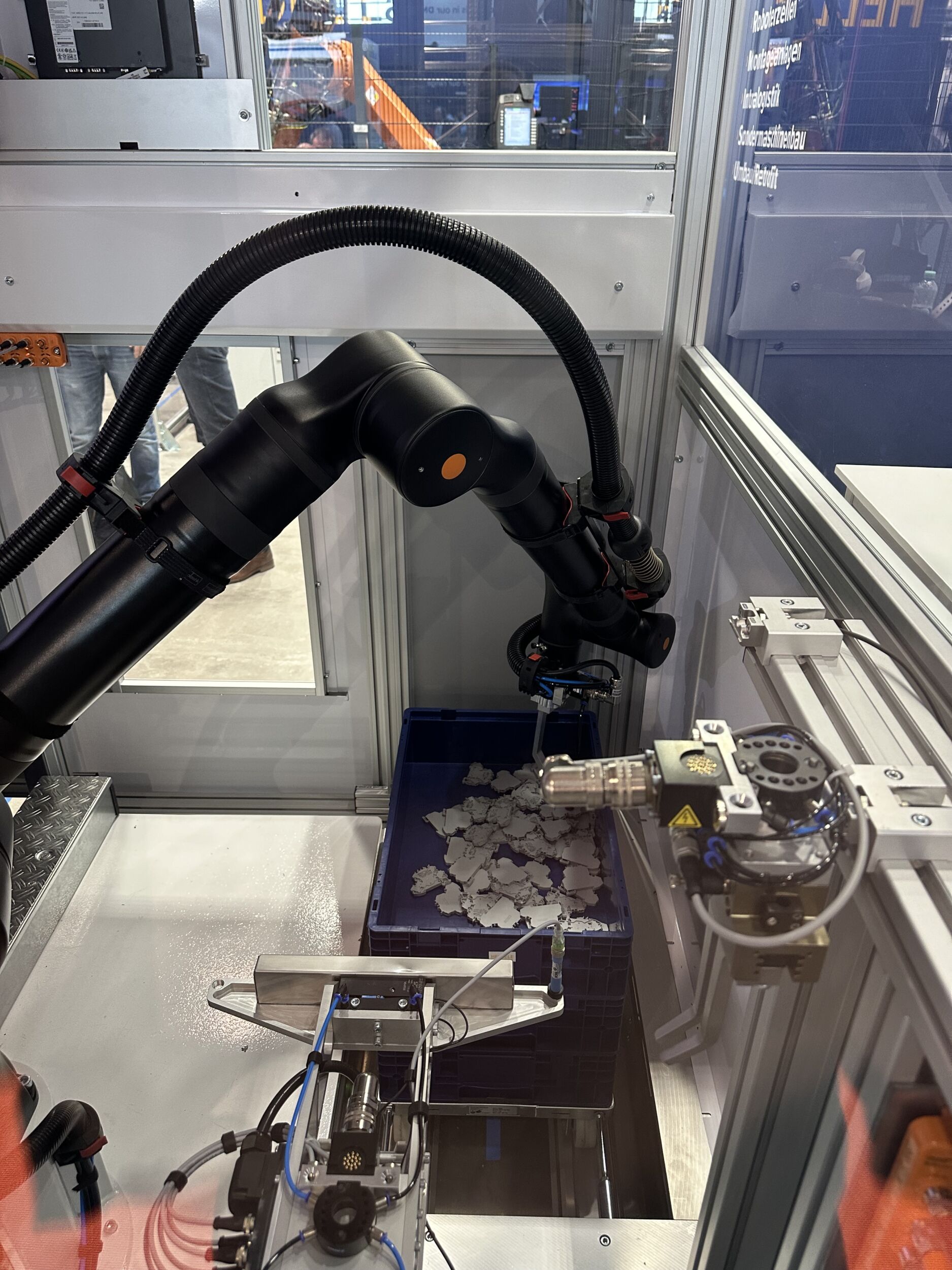

Vision Guided Robotics gewinnt an Bedeutung. Zunehmend kommen Bildverarbeitungssysteme und Robotik in industriellen Anwendungen gemeinsam zum Einsatz. Der spanische Bildverarbeitungsexperte Infaimon hat ein System für Bin-Picking entwickelt, bei dem zwei Kameras es Robotern ermöglichen, gezielt Objekte zu erkennen und zu greifen, die wahllos durcheinander in einem Behälter liegen.

Mit weniger als zehn Sekunden Bearbeitungszeit pro Gegenstand kann ein Bin-Picking-System einen Container schnell, fehlerfrei und ohne Unterbrechungen entleeren. (Bild: Infaimon S.L.)

Das Bin-Picking-System von Infaimon basiert auf Stereovision. Zwei hochauflösende Kameras, im Kopfteil des Roboters, liefern synchronisierte Bilder, die eine präzise 3D-Abbildung aller Gegenstände zulassen. Als künstliche Augen, die ein dreidimensionalles Bild erschaffen, wurden zwei GigE-Vision-Kameras von Allied Vision ausgewählt. Je nach Anforderung kommt entweder die kleine, kostengünstige Mako G-125 oder die leistungsfähige Prosilica GT1290 zum Einsatz. Um dem Roboterarm die notwendige Bewegungsfreiheit zu lassen, ist es wichtig, möglichst wenig Kabel zu verwenden. Beide GigE-Vision-Kameras benötigen dank Power-over-Ethernet (PoE) jeweils nur ein einziges Kabel für Stromversorgung und Datentransfer. „Um Objekte und deren Lage so schnell wie möglich identifizieren zu können, braucht das Bin-Picking-System möglichst kleine Kameras, die sich leicht synchronisieren lassen und deren Bildrate hoch genug ist“, beschreibt Salvador Giró, CEO von Infaimon in Barcelona, die Anforderungen an die Kameras. Die kompakte Mako G-125 (29x29mm) verfügt über zahlreiche Befestigungsmöglichkeiten. Die Kamera ist so klein und leicht, dass sie am Kopfende des Roboterarms eingebaut werden kann. Das macht die Nutz- und Bedienbarkeit des Systems noch leichter. Sie liefert Bilder mit einer Auflösung von 1.292×964 Pixel bei einer Bildrate von 30 Bildern pro Sekunde. Für echte Stereovision müssen beide Kameras zeitgleich Bilder aufnehmen und übertragen. Mit ihren zahlreichen Eingangs- und Ausgangsanschlüssen lässt sich die Kamera praktisch mit einem externen Trigger verbinden. Für anspruchsvollere Anwendungen, die synchronisierte Bilder bei schnellerer Auslesezeit fordern, kann das System auch mit der 1,2MP-Kamera Prosilica GT1290 ausgestattet werdet. Die Kamera verfügt über das Precision Time Protocol (PTP), das die genaue Synchronisation der Kameras über eine Ethernet-Verbindung ermöglicht. Eine der verbundenen Kameras übermittelt als Master-PTP-clock ein Synchronisierungssignal an alle anderen verbundenen Geräte. Sind alle Kameras und Geräte synchronisiert, können sie bis auf zwei Mikrosekunden genau synchron ausgelöst werden.

Erstellen einer 3D-Karte

Die zwei Kameras im Kopfteil des Roboterarms erzeugen ein 3D-Bild der identifizierten Gegenstände. (Bild: Infaimon S.L.)

Der erste Schritt im Picking-Prozess besteht im fehlerfreien Erkennen eines Teiles oder Gegenstandes, der aufgehoben werden soll. Dies erfordert höchst genaue 3D-Informationen über den Gegenstand. Da die Teile in jeder erdenklichen Lage wahllos durcheinander liegen können, muss das System in der Lage sein, die Gegenstände räumlich zu erkennen. Hierfür müssen alle Form bestimmenden Parameter des Objektes bekannt und im System erfasst sein. Wenn die Form des Gegenstandes und der umgebende Raum, in dem er sich befindet, bekannt sind, besteht der nächste Schritt darin, den Gegenstand zu finden. Die zwei Kameras im Kopfteil des Roboterarms erzeugen ein 3D-Bild der identifizierten Gegenstände. Das ist jedoch nicht die einzige Funktion der Kameras. Während der Roboterarm sich auf einem vordefinierten Weg durch den dreidimensionalen Raum bewegt, liefern die Kameras Hunderte Bilder, aus denen ein 3D-Bild des Raumes entsteht. Aufnahmen aus verschiedenen Blickwinkeln erstellen eine detaillierte 3D-Karte der gesamten Umgebung und lassen auch versteckte Teile oder Ecken sichtbar werden. Im nächsten Schritt wird der beste Kandidat unter all den erkannten Gegenständen bestimmt. Dieser ist von allen vorausgewählten Kandidaten am einfachsten für den Roboter zu greifen. Das trifft dann zu, wenn das Teil in greifbarer Nähe liegt und nicht von anderen Teilen eingekeilt oder überdeckt wird. Ist dieser beste Kandidat identifiziert, muss der Roboter diesen so schnell wie möglich ergreifen, ohne dabei andere Teile oder etwas im Arbeitsumfeld zu berühren. Dies setzt eine genaue Berechnung des idealen Weges voraus. Nachdem der Roboter diesen Gegenstand ergriffen hat, führt er ihn an eine genau vorbestimmte Position, damit der Produktionsprozess fortgesetzt werden kann. In einigen Anwendungen wird diese Phase genutzt, um ebenfalls mithilfe von industriellen Kameras Qualitätskontrollen an dem Teil durchzuführen.

Fazit

Mit weniger als zehn Sekunden Bearbeitungszeit pro Gegenstand kann ein Bin-Picking-System einen Container schnell, fehlerfrei und ohne Unterbrechungen entleeren. Die Möglichkeit, das System ununterbrochen im Schichtsystem zu nutzen, macht die Lösung besonders interessant für Unternehmen mit Dauerproduktion. „Außerdem sind die Hardware-Kosten beim Einsatz eines Stereovision-Systems im Vergleich zu anderen 3D-Systemen, die auf Lasertriangulation, Streifenprojektion oder Laufzeitverfahren basieren, günstig“, so Salvador Giró.