Podiumsdiskussion zum Thema 3D für die autonome mobile Robotik

Auf die Anwendung kommt es an …

Am dritten Tag der virtuellen Veranstaltung inVISION Days sprachen die Firmen DreamVu, Magazino, Mobile Industrial Robots und Sick auf einer Podiumsdiskussion via Zoom über das Thema ‚3D für die autonome mobile Robotik‘.

„Wir müssen technologische Entwicklungen kombinieren, um die Anzahl der Sensoren zu reduzieren.“ Mark Davidson, DreamVu (Bild: DreamVu Inc.)

ROBOTIK UND PRODUKTION: Wie würden Sie den idealen Sensor für die Navigation mobiler Roboter beschreiben?

Benjamin Sommer, Magazino: Wir verwenden viele verschiedene Arten von Sensoren für die Navigation. Aber es gibt eine Sache, die ich gerne erwähnen möchte: Es geht um die Frage der Sicherheit. Wir bei Magazino haben das Problem, dass wir mit unserem Laserscanner fast alles auf bodennaher Laserscanner-Höhe sehen können. Aber wenn es Tische oder andere Gegenstände in unterschiedlichen Höhen gibt, braucht der AMR-Markt definitiv bessere und einfachere Lösungen für die vertikale Objekterkennung. Wir sehen, dass die bisherigen Lösungen am Markt die Industrie nicht zu einer komplett sicheren und stabilen Umgebung verhelfen, und ich denke, das ist das größte Problem, das wir im Moment haben. Das wäre etwas, das wir im Hinblick auf den perfekten Sensor gerne lösen würden.

Jörg Faber, Mobile Industrial Robots: Die Sicherheit der Roboter hat auch für uns höchste Priorität. Obwohl Lidar-Systeme in etwa 20cm Höhe zuverlässig arbeiten, ist die Komplexität dessen, was sonst noch benötigt wird, um eine vollständige 3D-Ansicht der Umgebung zu erhalten, enorm hoch. Man muss sich kritische Fragen zu Design und Kosten stellen, da die Lösung auch marktgerecht hinsichtlich der Kosten sein muss. Die Integration von Technologien, um ein besseres Verständnis von allen relevanten 3D Informationen zu bekommen, ist zielführend. Eine entsprechende Lösung muss sicher und kosteneffektiv sein. Hinzu kommt, dass sich die Dynamik im industriellen Umfeld stetig verändert und sich neue Herausforderungen ergeben. Produktions- und Lagerhallen werden in diesem Zusammenhang immer felxibler. Daher ist es wichtig, agile Systeme anzubieten. Eine Reduzierung der Komplexität wird uns helfen, Fahrzeuge zu entwickeln, die noch benutzerfreundlicher sind. Dabei ist zwischen einem autonomen Roboter und einem FTS zu unterscheiden, da die Fahrzeuge jeweils andere Anforderungen stellen. Unser Anspruch für die Zukunft ist es, Flexibilität sicherzustellen.

„Wir brauchen noch weitere Entwicklungszeit, damit das autonome Fahren mit einem omnidirektionalen Antrieb möglich ist. Eine solche

Anwendung ist im Moment noch nicht sicher genug.“

Benjamin Sommer, Magazino (Bild: Magazino GmbH)

Sommer, Magazino: In der Welt der autonomen mobilen Roboter gibt es immer mehr komplexe Themen. Ich gebe Ihnen ein Beispiel: Wir verwenden derzeit omnidirektionale Antriebe. Es ist dabei sehr schwierig, mit zwei Sensoren auszukommen, denn vier Sensoren sind natürlich in den meisten Fällen zu teuer. Wir fahren in eine bestimmte Richtung und mit einem Weitwinkel sehen wir links und rechts etwas. Und dann, wenn wir links daneben sind, müssen wir verstehen oder noch im Gedächtnis haben, was wir gesehen haben. Das ist eigentlich ein technologischer White Spot, mit dem die aktuellen Sensoren nicht wirklich umgehen können. Fahren mit einem omnidirektionalen Antrieb ist möglich und sicher, aber wenn auch bei seitlichem Fahren eine Maximalgeschwindigkeit genutzt werden soll, werden noch Optimierungen in der Sensorentwicklung benötigt.

Faber, Mobile Industrial Robots: Die Vorausschau hilft unseren Robotern dabei, Entscheidungen zu treffen und sich zurechtzufinden – unabhängig von der verwendeten Technologie. Auf der anderen Seite steht jedoch auch die Frage, wie genau wir messen können. Wenn die Roboter interagieren und sich ihrem Ziel nähern, ist Genauigkeit essenziell. Ändern wir also ein Element, muss jedes physikalische System die gleichen oder bessere Messdaten liefern, um die Position genau zu bestimmen. Die Messlatte liegt also hoch, während der Preis so niedrig wie möglich sein sollte.

Dr. Anatoly Sherman, Sick: Es gibt die verschiedenen Anwendungsfälle und es gibt das Thema von Preis und Leistung. Wir sehen einen sehr dynamischen Markt. Jeden Monat gibt es eine neue große Verbesserung in der Auflösung oder in der Genauigkeit. Man braucht verschiedene Sensoren, um die perfekte Navigation zu ermöglichen. Darüber hinaus sind die Sicherheitsaspekte sehr wichtig. Es gibt verschiedene Arten von Technologien. 3D-Technologien sind je nach Anwendungsfall für einen bestimmten Roboter besser oder weniger gut geeignet. Es gibt natürlich keinen perfekten Sensor, sondern es kommt auf den spezifischen Fahrzeugtyp und die spezifischen Aufgaben an, die dieses Fahrzeug zu erfüllen hat.

„Eine Verringerung der Komplexität

wird uns helfen, Fahrzeuge zu

entwickeln, die benutzerfreundlich sind.

Unsere Zukunft ist es, flexibel zu sein.“

Jörg Faber, Mobile Industrial Robots (Bild: Mobile Industrial Robots ApS)

Mark Davidson, DreamVu: Ein Sensor, der alles sieht, der genau weiß, was alles ist, der genau weiß, wo man sich befindet, der keinen Strom verbraucht und kostenlos ist – das wäre der ideale Sensor. Wir werden dieses Ziel natürlich nicht erreichen. Aber wenn wir anfangen, technologische Entwicklungen zu kombinieren, die entweder die Interoperabilität mehrerer Sensoren ermöglichen oder alle in einen Sensor integriert sind, werden wir die Anzahl der Sensoren reduzieren können. Und ich denke das ist es, was unsere Kunden wollen. Natürlich gibt es keinen idealen Sensor. Aber wir bei DreamVu sind der Meinung, dass wir etwas auf den Markt bringen können, das mit den Erwartungen mithalten kann, wie z.B. geringere Kosten und geringerer Stromverbrauch. Wir wollen etwas entwickeln, das das Leben unserer Kunden einfacher macht und eine sichere und effiziente, kostengünstige AMR-Anwendung ermöglicht.

ROBOTIK UND PRODUKTION: Welche 3D-Verfahren werden heute und in Zukunft zur Steuerung von Robotern eingesetzt?

Sherman, Sick: Das hängt vom Preis/Leistungs-Verhältnis, der Architektur des Roboters und der spezifischen Anwendung ab. Ich denke, dass derzeit die 3D-Technologien im Kommen sind. Es könnten 3D-Time-of-Flight, eine stereobasierte , 2D Vision oder Lidar-Technologie sein. Ich denke, der Schlüssel wird eine Art Mix aus diesen Verfahren sein. Und natürlich wird das Gehirn, das all diese Technologien auswertet, der Schlüssel sein, um sie auf die nächste Stufe zu heben.

Magazino and MIR: Welche Technologien verwenden Sie und welche Hindernisse müssen noch überwunden werden? Oder was sind derzeit die Hauptprobleme der Anwender?

Sommer, Magazino: Man muss wirklich sehr anwendungsspezifisch vorgehen. Nehmen wir also unseren speziellen Anwendungsfall eines AMR, der in einem Lagerhaus kollaborativ fährt, wo es viele verschiedene Hindernisse in unterschiedlichen Höhen gibt. Die Technik, die wir derzeit bevorzugen, sind Lidar-Sensoren, wie Laserscanner, zwei bis drei auf einer bestimmten Höhe, etwa 15cm. Dann verwenden wir Time-of-Flight-Sensoren, zwei an der Vorder- und Rückseite, um mit einem bestimmten Winkel den Bereich vor uns und verschiedene Hindernisse zu erfassen. Und dann haben wir noch ein zweites großes Problem, nämlich das, was wirklich auf dem Boden oder in Bodennähe unter 20cm Höhe passiert. Das ist wirklich schwer zu erkennen. Eine weitere Option ist es, in Zukunft Ultraschallsensoren einzusetzen, die für diese Art von Dingen am Boden wirklich geeignet sind. Sie sind nicht wirklich präzise und nicht wirklich in der Lage herauszufinden, wo genau sich ein Objekt befindet. Wir können die Time-of-Flight-Sensorik dafür verwenden, aber wir sind nur mit der Ultraschallsensorik tatsächlich in der Lage, etwas zu erkennen, wo die Time-of-Flight-Sensorik ihre Schwierigkeiten hat, besonders in der Entfernung und in Bodennähe. Das ist also unser Mix, um die Navigation in Zukunft sicher in den Griff zu bekommen.

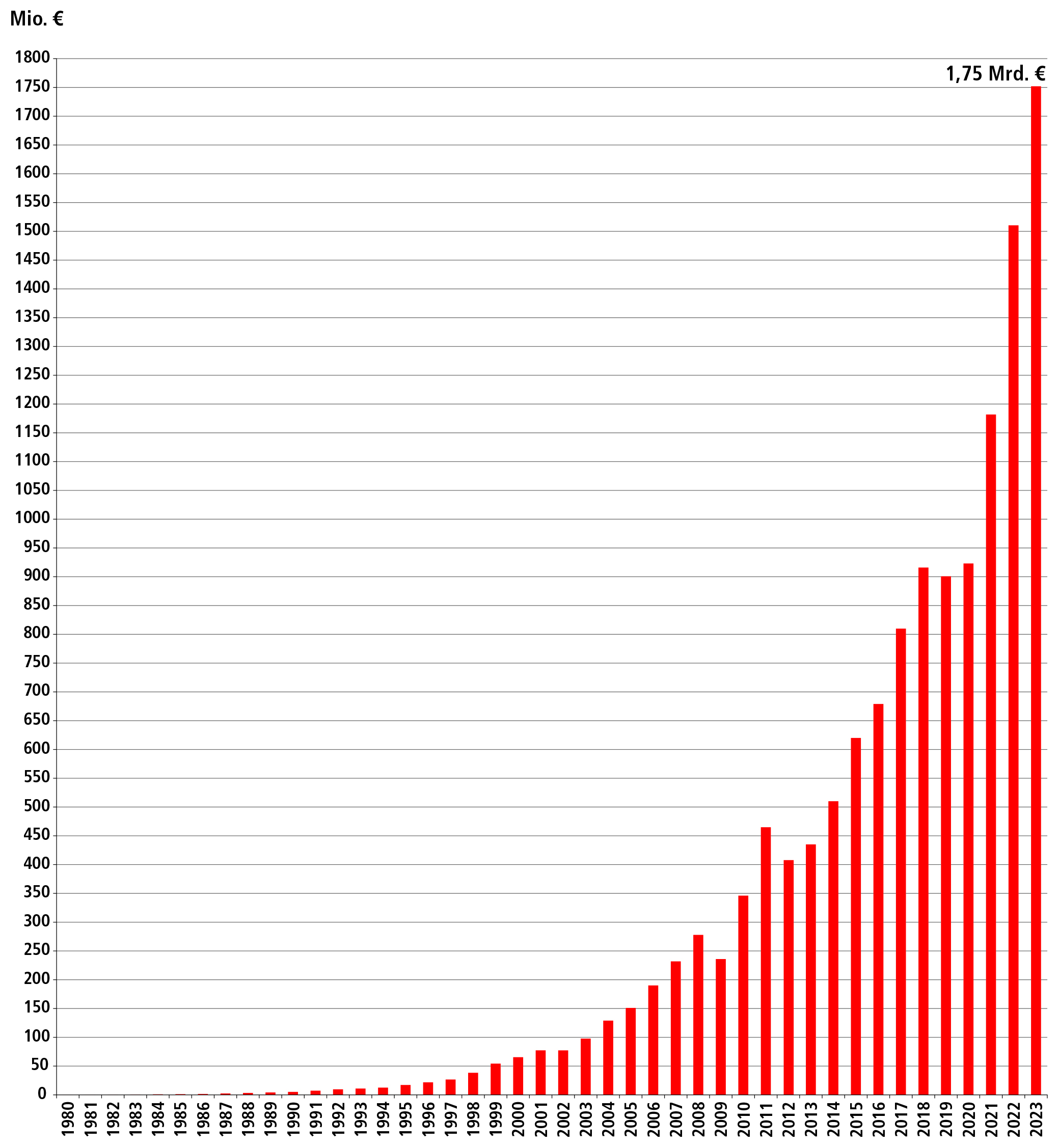

Faber, Mobile Industrial Robots: Unsere AMRs fahren nur in Innenräumen, genauer gesagt kommen sie in der Intralogistik zum Einsatz. Das Gewicht, das sie transportieren können, liegt unter zwei Tonnen. Für die sichere Navigation sind standardmäßig zwei Laserscanner in jedem Fahrzeug verbaut. Zwei 2D-Kameras liefern uns Informationen neben den Laserscannern, so dass wir ein 3D-Bild erhalten. Wir verwenden außerdem Nahfeldsensoren, vor allem Ultraschall-Nahfeldsensoren, um sicherzustellen, dass wenn das Fahrzeug anfahren soll keine Hindernisse in der Nähe bestehen. Die Kombination an Sensoren kommt bereits heute zum Einsatz. In Zukunft wollen wir die Komplexität weiter reduzieren. Dabei gehen wir sehr kostenbewusst vor, denn es geht immer auch um Marktanteile und Volumen. MiR baut Standardfahrzeuge. Denn der Markt für mobile Roboter wird immer größter: die prognostizierte jährliche Wachstumsrate liegt bei 30 bis 40 Prozent.

ROBOTIK UND PRODUKTION: Es ist notwendig, die Daten von mehr als einem Sensor zu analysieren. Ist es dafür nötig, eine Sensorfusion durchzuführen, oder kann künstliche Intelligenz diese Systeme leistungsfähiger, einfacher und schneller machen?

Sherman, Sick: Natürlich ist die Sensorfusion eines der Hauptthemen, mit denen wir uns derzeit beschäftigen. Wir haben verschiedene Verfahren wie Stereo, Time-of-Flight-Lidar oder Solid-State und natürlich bieten wir Plug&Play- oder Out-of-the-Box-Lösungen an. Wir müssen all diese Daten analysieren, und künstliche Intelligenz ist derzeit eines der leistungsfähigsten Werkzeuge dafür. Vor allem mit der 3D-Technik erhält man eine Vielzahl von Informationen, die man in Echtzeit verarbeiten muss. Es ist eine Tatsache, dass KI-Methoden allmählich zum Stand der Technik werden, um die immense anfallende Datenmenge zu verarbeiten.

Faber, Mobile Industrial Robots: MIR ist mit seinen Produkten seit etwa sechs Jahren auf dem Markt und natürlich sind Rechenleistung, eine ausgefeilte Software Architektur und ein sinnvoller Energieverbrauch wichtig. Wir beobachten, wie erstere stetig zunimmt. Die beste Art und Weise, dies zu nutzen, ist künstliche Intelligenz. Sie ist das Buzz Word, um viele anstehende Aufgaben zu lösen, aber sie tut es nicht von selbst. Auch hier muss noch Arbeit investiert werden, um ein effizientes System zu erhalten. Realistisch gesehen ist das jedoch kein Prozess, der von heute auf morgen erfolgt.

Sommer, Magazino: Wir verwenden eine bestimmte Kameratechnik für das Greifen, Aufnehmen und Handhaben von Objekten, zum Beispiel Schuhkartons. Sie sind unterschiedlich angeordnet und der AMR muss in der Lage sein, sie zu erkennen. Wir setzen also 2D- und 3D-Technologie ein, um herauszufinden, wo sich das Objekt tatsächlich befindet. Dazu werden eine Menge Daten herangezogen. Mithilfe von KI und maschinellem Lernen können wir herausfinden, wie wir den nächsten Pick durchführen können. Es geht nicht nur um die Bilder oder Sensordaten von 3D- oder 2D-Kameras, sondern man braucht die Kombination mit anderen Technologien, um einen echten Mehrwert zu erzielen.

„Es ist eine Tatsache, dass KI-Methoden

bei der Datenverarbeitung immer mehr

zum Stand der Technik werden. KI ist ein Enabler für mehr Effizienz in der Produktion.“

Dr. Anatoly Sherman, Sick (Bild: Sick AG)

Davidson, DreamVu: Ja, die Verarbeitungskapazität wächst, sodass mehr Rechenleistung für die Sensorfusion zur Verfügung steht. Wir wollen nicht einen Großteil dieser Verbesserungen und Fähigkeiten vergeuden, nur weil wir krampfhaft versuchen, alle Sensorsdaten zusammenzubringen. Ein solcher Ansatz ist meiner Meinung nach Verschwendung. Wir sollten die Fusion vereinfachen und die neuen Entwicklungen der Chip-Hersteller nutzen, um dem Roboter mehr Intelligenz zu verleihen, damit er bessere Entscheidungen treffen und effektiver arbeiten kann.

Sherman, Sick: Die eine Sache ist die Datenfusion, die andere die KI. Man kann KI als Werkzeug für diverse Zwecken nutzen wie für die Datenfusion, z.B. wenn man verschiedene Quellen hat und etwa die Daten von Laserscannern, 3D- oder 2D-Kameras auswerten muss. Wenn man also alle Daten auf der Produktionsebene auswerten will, braucht man KI. KI ist ein Enabler für mehr Effizienz in der Produktion.

ROBOTIK UND PRODUKTION: Wann rechnen Sie damit, dass sich die Feature-Based-Navigation bei mobilen Robotern durchsetzen wird?

Sommer, Magazino: Eher früher als später. Wir haben bereits einen großen Wechsel auf dem Markt erlebt und dasselbe gilt für die kognitive oder kollaborative Robotik der letzten Jahre. Dasselbe gilt ein Stück weit auch für den Übergang von FTS zu AMR, bei dem es hauptsächlich um Feature-Based-Navigation ging. Es ist ein wirklich großer Prozess in dieser Richtung im Gange. Eine der Hauptfragen dabei wird sein, ob die Feature-Based-Navigation mit kollaborativen AMRs genauso zuverlässig sein wird wie der klassische FTS-Ansatz. Ich denke, wir müssen dem Markt wirklich beweisen, dass die Feature-Based-Navigation in der Lage ist, dieses Thema zu bewältigen, und ich hoffe, dass dies innerhalb der nächsten zwei bis vier Jahre gelingen wird.

Faber, Mobile Industrial Robots: Aber es muss nachweisbar sicher sein. Sicherheit ist hier das Schlüsselelement.

Sherman, Sick: Und der Punkt ist: Sicherheit ist direkt mit einer bestimmten technologischen Entwicklung verbunden, die derzeit von 2D-Scannern dominiert wird. Wir denken nicht an Feature-Based-Navigation, wir denken an visuelle Wahrnehmung. In Zukunft wird es eine Sensortechnik geben, die beides leisten kann.

Davidson, DreamVu: Das Argument der Sicherheit ist unbestreitbar. Wir führen viele Gespräche mit Anwendern, und der größte Wunsch ist die Unterstützung bei der Lokalisierung. Denn mit der Feature-Based-Navigation können wir reale Dinge erkennen und Objekte ganz neu klassifizieren. Das ist ein Bereich, in dem sich die Anwender die Unterstützung durch unser Bildverarbeitungssystem wünschen, und zwar in Kombination mit einem 2D-Scanner und Laser-Technik. Ich denke, dass zwei bis vier Jahre Entwicklungszeit hier durchaus richtig angesetzt sind.